Googleの機械学習の多くはオープンソースで、開発者は最新の技術を利用することができます。最新のリリースは、セマンティックイメージセグメンテーション、またはPixel 2のシングルレンズポートレートモードの裏側にある技術です。

ポートレートモード裏側にある技術、機械学習モデル

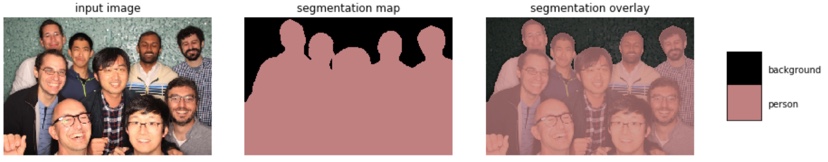

このディープラーニングモデルは、セマンティックラベルを画像内のすべてのピクセルに割り当てます。次に、カテゴリ化によって道路、空、人、または犬のような分類が可能になり、写真のどの部分が背景であり、どの部分が前景であるかが分かります。

この技術は。物理的なレンズが1つしかない浅い被写界深度のカメラに被写界深度の効果を作り出すため、Pixel 2のポートレートモードで活用されます。この技術は、特に、オブジェクトの輪郭を特定する、または人物がどこで終わり、背景が始まるかを区別する際に最適化されます。

これらのセマンティックラベルを割り当てることは、オブジェクトの輪郭を正確に特定することを必要とするため、画像レベル分類または境界ボックスレベル検出などの他の視覚的エンティティ認識タスクよりもはるかに厳しい位置決定精度要件を必要とします。

DeepLab-v3では、オブジェクト境界に沿ったパフォーマンスを最適化するデコーダモジュールにより、これが可能になりました。このセマンティックイメージセグメンテーションモデルは、Pixel 2とPixel 2 XLで利用可能にします。 TensorFlowで実装され、このリリースにはモデルトレーニングと評価コードも含まれています。

Googleは、精度レベルは5年前には想像もできなかったが、ハードウェア、方法、およびデータセットの進歩によって可能になったといいます。